Fabrice AI er en digital repræsentation af mine tanker baseret på alt indholdet på min blog. Den er tænkt som en interaktiv, intelligent assistent, der er i stand til at forstå og svare på komplekse forespørgsler på en nuanceret og præcis måde.

Fabrice AI begyndte som et eksperiment, en personlig søgen efter at udforske potentialet i kunstig intelligens ved at skabe en digital version af den omfattende viden, jeg havde delt i årenes løb. Oprindeligt forestillede jeg mig, at det var et ligetil projekt, som kunne gennemføres i løbet af få timer. Planen var enkel: at uploade mit indhold til OpenAI’s API og lade AI’en interagere med det og derved skabe en tilgængelig, intelligent assistent, der kunne give nuancerede svar baseret på det væld af oplysninger, jeg havde delt.

Men da jeg begav mig ud på denne rejse, blev det hurtigt klart, at opgaven var langt mere kompleks, end jeg havde forventet. Projektet, som jeg troede ville være en kort afstikker til AI, udviklede sig hurtigt til et omfattende og indviklet projekt, der krævede langt mere end blot en overfladisk upload af data. Det blev til et dybt dyk ned i de indviklede aspekter af AI, naturlig sprogbehandling og vidensstyring.

Den centrale udfordring, jeg stod over for, handlede ikke kun om at lagre information, men også om at lære den kunstige intelligens at forstå, kontekstualisere og genfinde informationen på en måde, der afspejlede dybden og nuancerne i mit oprindelige indhold. Det krævede en mangesidet tilgang, da jeg opdagede, at simple metoder til datalagring og -hentning var utilstrækkelige i forhold til kompleksiteten af de spørgsmål, jeg ønskede, at Fabrice AI skulle håndtere.

Rejsen førte mig gennem en lang række tilgange, fra de første forsøg på at bruge vektorsøgeindekser til mere avancerede metoder, der involverede vidensgrafer, metadatahentning og specialbyggede AI-modeller. Hver tilgang havde sine egne styrker og svagheder, og hver gang lærte jeg noget nyt om kompleksiteten i AI og nuancerne i digital vidensstyring. Jeg vil beskrive den tekniske vej i detaljer i det næste blogindlæg.

Ud over de tekniske problemer viste det sig også at være en udfordring at skabe en udtømmende vidensbase. I de tidlige faser med at teste AI’ens nøjagtighed gik det op for mig, at de mest detaljerede og nøjagtige svar på nogle spørgsmål var dem, jeg gav i videointerviews eller podcasts. For at være præcis havde jeg brug for, at vidensbasen indeholdt alle mine indlæg, videointerviews, podcasts, PowerPoint-præsentationer, billeder og PDF-dokumenter.

Jeg startede med at transskribere alt indholdet. Da de automatiske transskriptioner er omtrentlige til at begynde med, var jeg nødt til at sikre mig, at AI’en forstod indholdet. Det tog lang tid, da jeg var nødt til at teste svarene for hvert stykke transskriberet indhold.

Selvom transskriptionerne adskilte mig fra den anden taler, troede AI’en først, at 100 % af det talte indhold var mit, hvilket krævede en masse yderligere træning for at sikre, at den kunne skelne mellem begge talere korrekt på alt indhold. Jeg ønskede også, at Fabrice AI skulle lægge mere vægt på nyere indhold. Første gang jeg prøvede det, brugte den selvfølgelig den dato, hvor jeg uploadede indholdet til LLM, i stedet for den dato, hvor jeg oprindeligt postede artiklen, hvilket krævede yderligere justeringer.

For fuldstændighedens skyld transskriberede jeg også viden i slides, som jeg delte på bloggen, ved at bruge OCR-modellen i Azure til konvertering af billeder til tekst og uploadede derefter filerne til GPT-assistentens vidensbase. På samme måde downloadede jeg PDF’er fra WordPress’ mediebibliotek og uploadede dem til vidensbasen.

Under betatesten lagde jeg mærke til, at mange af mine venner stillede personlige spørgsmål, som ikke blev dækket på bloggen. Jeg venter på at se, hvilke typer spørgsmål folk stiller i løbet af de næste par uger. Jeg vil færdiggøre svarene, hvis de ikke kan findes med det eksisterende indhold på min blog. Bemærk, at jeg med vilje begrænser svarene fra Fabrice AI til indholdet på bloggen, så du virkelig får Fabrice AI og ikke en blanding af Fabrice AI og Chat GPT.

Det er værd at nævne, at jeg tog en lang vej for at nå hertil. Jeg startede med at bruge GPT3, men blev skuffet over resultaterne. Den blev ved med at bruge de forkerte kilder til at besvare spørgsmålene, selv om nogle blogindlæg havde præcis det svar, som spørgsmålet lød på. Selv om jeg brugte mange timer på at forsøge at få den til at bruge det rigtige indhold (hvilket jeg vil fortælle om i næste blogindlæg), fik jeg aldrig resultater, jeg var tilfreds med.

Det blev bedre med GPT3.5, men det var stadig skuffende. Derefter byggede jeg en GPT-applikation i GPT Store ved hjælp af GPT Builder. Det fungerede lidt bedre og var billigere i drift. Men jeg kunne ikke få den til at køre på min hjemmeside, og den var kun tilgængelig for betalende abonnenter på Chat GPT, hvilket jeg følte var for begrænsende. Uanset hvad var jeg ikke vild med kvaliteten af svarene og havde det ikke godt med at frigive den til offentligheden.

Gennembruddet kom med udgivelsen af GPT Assistants, der bruger model 4o. Uden at jeg behøvede at fortælle den, hvilket indhold den skulle bruge, begyndte den selv at finde ud af det, og alt fungerede bare bedre. Jeg droppede GPT-applikationen og gik tilbage til at bruge API’en, så jeg kunne integrere den på bloggen. For fuldstændighedens skyld testede jeg også Gemini, men jeg foretrak svarene fra GPT4o.

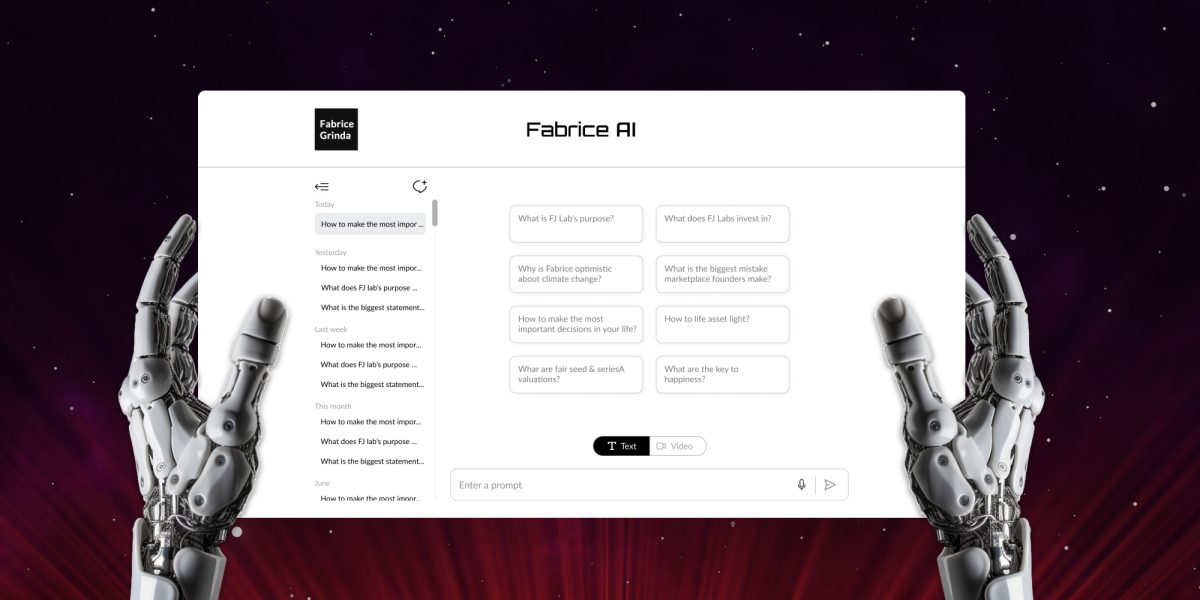

Jeg udgiver en ren tekstversion indtil videre. Den indeholder en stemme-til-tekst-funktion, så du kan stille dine spørgsmål med stemmen. Jeg leger med et par måder at kode en interaktiv version, der ser ud og lyder som mig, og som man kan føre en samtale med. Jeg har en fungerende prototype, men er langt fra tilfreds med resultaterne og de potentielle omkostninger. Jeg vil være sikker på, at den taler i første person, virkelig ser ud og lyder som mig og ikke koster en arm og et ben for mig at betjene.

Vi må se, hvor langt jeg kommer i de kommende måneder, men måske giver det bare mening at vente på GPT5. Set i bakspejlet ville jeg have sparet hundredvis af arbejdstimer, hvis jeg bare havde ventet på GPT4o med at udvikle Fabrice AI. Men på den anden side var undersøgelsen en del af pointen, og den var super interessant.

I mellemtiden kan du lege med Fabrice AI og fortælle mig, hvad du synes!