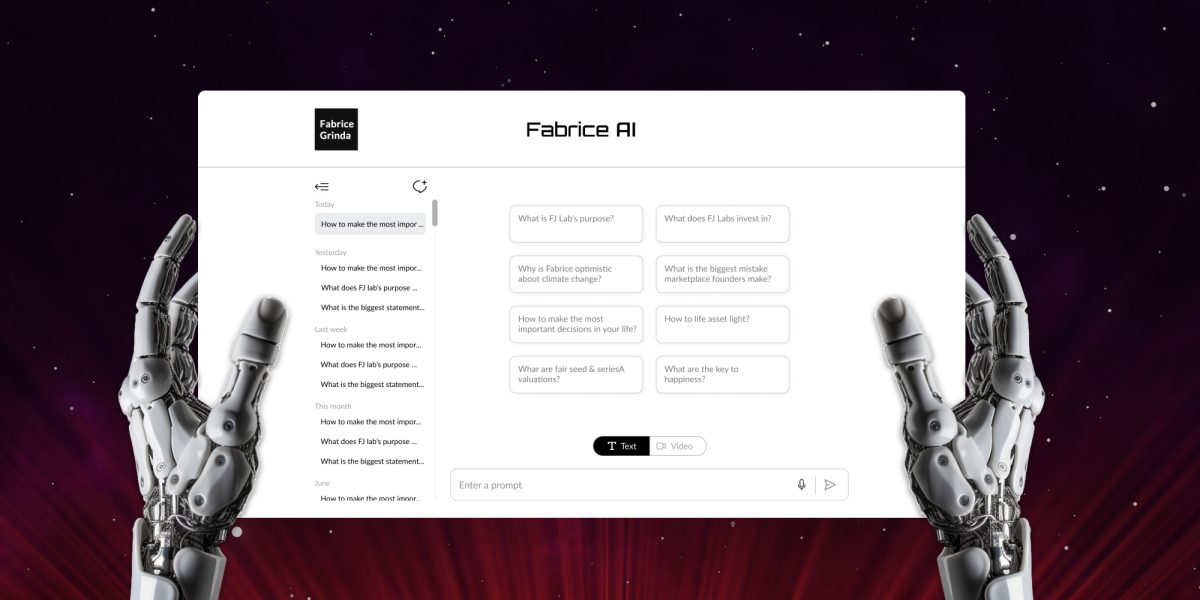

Fabrice AI میرے بلاگ کے تمام مواد پر مبنی میرے خیالات کی ڈیجیٹل نمائندگی ہے۔ اس کا مطلب ایک انٹرایکٹو، ذہین اسسٹنٹ ہے جو پیچیدہ سوالات کو سمجھنے اور ان کا جواب دینے کی صلاحیت اور درستگی کے ساتھ ہے۔

Fabrice AI کا آغاز ایک تجربے کے طور پر ہوا، ایک ذاتی جستجو مصنوعی ذہانت کی صلاحیت کو دریافت کرنے کے لیے وسیع علم کا ڈیجیٹل ورژن بنا کر جو میں نے سالوں میں شیئر کیا تھا۔ ابتدائی طور پر، میں نے اسے ایک سیدھے سادھے منصوبے کے طور پر تصور کیا، جو کچھ گھنٹوں میں مکمل ہو سکتا ہے۔ منصوبہ آسان تھا: میرا مواد OpenAI کے API میں اپ لوڈ کریں اور AI کو اس کے ساتھ تعامل کرنے کی اجازت دیں، اس طرح ایک قابل رسائی، ذہین اسسٹنٹ بنایا جائے جو میرے اشتراک کردہ معلومات کی دولت کی بنیاد پر مختصر جوابات فراہم کر سکے۔

تاہم، جیسے ہی میں نے اس سفر کا آغاز کیا، یہ جلد ہی ظاہر ہو گیا کہ یہ کام میری توقع سے کہیں زیادہ پیچیدہ تھا۔ پروجیکٹ، جس کے بارے میں میں نے سوچا تھا کہ AI میں ایک مختصر قدم ہوگا، تیزی سے ایک جامع اور پیچیدہ کوشش میں پھیل گیا، جس میں ڈیٹا کے محض سطحی اپ لوڈ سے کہیں زیادہ کی ضرورت ہوتی ہے۔ یہ AI، قدرتی زبان کی پروسیسنگ، اور علم کے انتظام کی پیچیدگیوں میں ایک گہرے غوطے میں بدل گیا۔

مجھے جس بنیادی چیلنج کا سامنا کرنا پڑا وہ صرف معلومات کو ذخیرہ کرنے کے بارے میں نہیں تھا، یہ AI کو اس معلومات کو سمجھنے، سیاق و سباق کے مطابق بنانے، اور درست طریقے سے اس معلومات کو بازیافت کرنا سکھانے کے بارے میں تھا جو میرے اصل مواد کی گہرائی اور اہمیت کو ظاہر کرتا تھا۔ اس کے لیے ایک کثیر جہتی نقطہ نظر کی ضرورت تھی، جیسا کہ میں نے دریافت کیا کہ ڈیٹا ذخیرہ کرنے اور بازیافت کرنے کے آسان طریقے ان سوالات کی پیچیدگی کے لیے ناکافی تھے جن کو میں Fabrice AI کو سنبھالنا چاہتا تھا۔

اس سفر نے مجھے ویکٹر سرچ انڈیکس استعمال کرنے کی ابتدائی کوششوں سے لے کر نالج گرافس، میٹا ڈیٹا کی بازیافت، اور حسب ضرورت AI ماڈلز پر مشتمل مزید جدید طریقوں تک وسیع پیمانے پر طریقوں سے گزرا۔ ہر نقطہ نظر کی اپنی طاقتوں اور کمزوریوں کا ایک سیٹ تھا، اور ہر ایک نے مجھے AI کی پیچیدگیوں اور ڈیجیٹل علم کے انتظام کی باریکیوں کے بارے میں کچھ نیا سکھایا۔ میں اگلی بلاگ پوسٹ میں اختیار کیے گئے تکنیکی راستے کو تفصیل سے بیان کروں گا۔

درپیش تکنیکی مسائل کے علاوہ، ایک جامع علمی بنیاد پیدا کرنا بھی چیلنجنگ ثابت ہوا۔ AI کی درستگی کو جانچنے کے ابتدائی مراحل میں، یہ بات میرے ذہن میں آ گئی کہ کچھ سوالات کے سب سے زیادہ مفصل اور درست جواب وہ تھے جو میں نے ویڈیو انٹرویوز یا پوڈ کاسٹ میں دیے۔ درست ہونے کے لیے، مجھے اپنی تمام پوسٹس، ویڈیو انٹرویوز، پوڈکاسٹ، پاورپوائنٹ پریزنٹیشنز، تصاویر اور پی ڈی ایف دستاویزات شامل کرنے کے لیے علمی بنیاد کی ضرورت تھی۔

میں نے تمام مواد کو نقل کرکے شروع کیا۔ یہ دیکھتے ہوئے کہ خودکار ٹرانسکرپشنز شروع ہونے کے لیے لگ بھگ ہیں، مجھے یہ یقینی بنانا تھا کہ AI مواد کو سمجھتا ہے۔ اس میں کافی وقت لگا کیونکہ مجھے نقل کردہ مواد کے ہر ٹکڑے کے جوابات کی جانچ کرنی تھی۔

اگرچہ ٹرانسکرپشنز نے مجھے دوسرے سپیکر سے الگ کر دیا، AI نے پہلے سوچا کہ بولا جانے والا 100% مواد میرا ہے جس کو یہ یقینی بنانے کے لیے بہت زیادہ تربیت کی ضرورت ہے کہ یہ تمام مواد پر دونوں اسپیکرز کو صحیح طریقے سے الگ کر سکے۔ میں یہ بھی چاہتا تھا کہ Fabrice AI حالیہ مواد کو زیادہ وزن دے۔ بلاشبہ، میں نے پہلی بار کوشش کی کہ اس نے وہ تاریخ استعمال کی جس میں میں نے LLM پر مواد اپ لوڈ کیا تھا بجائے اس کے کہ میں نے مضمون کو اصل میں پوسٹ کیا تھا، جس میں مزید ایڈجسٹمنٹ کی ضرورت تھی۔

مکمل ہونے کی خاطر، میں نے بلاگ پر شیئر کی گئی سلائیڈز میں علم کو بھی نقل کیا جس میں Azure میں OCR ماڈل کو امیج سے ٹیکسٹ کنورژن کے لیے استعمال کیا گیا اور پھر فائلوں کو GPT اسسٹنٹ نالج بیس پر اپ لوڈ کیا۔ اسی طرح، میں نے ورڈپریس کی میڈیا لائبریری سے پی ڈی ایفز ڈاؤن لوڈ کیں اور انہیں نالج بیس پر اپ لوڈ کیا۔

بیٹا ٹیسٹنگ کے دوران، میں نے دیکھا کہ میرے بہت سے دوستوں نے ذاتی سوالات پوچھے جن کا بلاگ پر احاطہ نہیں کیا گیا تھا۔ میں اگلے چند ہفتوں میں لوگوں کے پوچھے جانے والے سوالات کی اقسام دیکھنے کا انتظار کر رہا ہوں۔ میں جوابات مکمل کروں گا اگر وہ میرے بلاگ پر موجود مواد کے ساتھ نہ مل سکے۔ نوٹ کریں کہ میں جان بوجھ کر Fabrice AI کے جوابات کو بلاگ پر موجود مواد تک محدود کر رہا ہوں، لہذا آپ کو واقعی Fabrice AI ملے گا نہ کہ Fabrice AI اور Chat GPT کا مرکب۔

یہ بات قابل ذکر ہے کہ میں نے یہاں تک پہنچنے کے لیے ایک طویل راستہ اختیار کیا۔ میں نے GPT3 کا استعمال کرکے شروعات کی لیکن نتائج سے مایوس ہوا۔ یہ سوالات کے جوابات دینے کے لیے غلط ذرائع کا استعمال کرتا رہا حالانکہ کچھ بلاگ پوسٹس میں سوال کا بالکل وہی جواب تھا۔ اس مسئلے پر دسیوں گھنٹے کام کرنے کے باوجود اسے صحیح مواد استعمال کرنے کی کوشش کرنے کے باوجود (جس کا میں اگلی بلاگ پوسٹ میں احاطہ کروں گا)، مجھے کبھی بھی ایسے نتائج نہیں ملے جن سے میں مطمئن ہوں۔

GPT3.5 کے ساتھ چیزیں بہتر ہوئیں لیکن پھر بھی مایوس کن تھیں۔ پھر میں نے GPT Builder کا استعمال کرتے ہوئے GPT اسٹور میں ایک GPT ایپلیکیشن بنایا۔ اس نے تھوڑا بہتر کام کیا اور کام کرنا سستا تھا۔ تاہم، میں اسے اپنی ویب سائٹ پر چلانے کے لیے حاصل نہیں کر سکا، اور یہ صرف چیٹ GPT کے ادا شدہ سبسکرائبرز کے لیے دستیاب تھا جسے میں نے محسوس کیا کہ یہ بہت محدود ہے۔ قطع نظر، مجھے جوابات کا معیار پسند نہیں تھا اور میں اسے عوام کے لیے جاری کرنے میں آرام سے نہیں تھا۔

پیش رفت ماڈل 4o کا استعمال کرتے ہوئے GPT معاونین کی رہائی کے ساتھ آئی۔ مجھے یہ بتانے کی ضرورت کے بغیر کہ کون سا مواد استعمال کرنا ہے، اس نے خود ہی اس کا پتہ لگانا شروع کیا اور سب کچھ بہتر کام کر گیا۔ میں نے GPT ایپلیکیشن اپروچ کو ختم کر دیا اور API کا استعمال کرنے کے لیے واپس چلا گیا تاکہ میں اسے بلاگ پر ایمبیڈ کر سکوں۔ تھکن کی خاطر، میں نے Gemini کا بھی تجربہ کیا، لیکن GPT4o کی طرف سے دیے گئے جوابات کو ترجیح دی۔

میں فی الحال صرف ٹیکسٹ ورژن جاری کر رہا ہوں۔ اس میں آواز سے متن کی خصوصیت شامل ہے تاکہ آپ آواز کے ذریعے اپنے سوالات پوچھ سکیں۔ میں ایک انٹرایکٹو ورژن کو کوڈ کرنے کے چند طریقوں کے ساتھ کھیل رہا ہوں جو لگتا ہے اور میری طرح لگتا ہے جس سے آپ بات چیت کر سکتے ہیں۔ میرے پاس ایک ورکنگ پروٹو ٹائپ ہے لیکن میں نتائج اور ممکنہ لاگت سے بہت خوش ہوں۔ میں اس بات کو یقینی بنانا چاہتا ہوں کہ یہ پہلے شخص میں بولتا ہے، واقعی لگتا ہے اور میری طرح لگتا ہے، اور مجھے چلانے کے لیے ایک بازو اور ایک ٹانگ کی قیمت نہیں لگتی ہے۔

ہم دیکھیں گے کہ آنے والے مہینوں میں میں کتنی پیشرفت کرتا ہوں، لیکن جی پی ٹی 5 کا انتظار کرنا سمجھ میں آ سکتا ہے۔ اگر میں فیبریس اے آئی تیار کرنے کے لیے صرف GPT4o کا انتظار کر لیتا تو پیچھے کی نظر میں، میں کام کے سینکڑوں گھنٹے بچا لیتا۔ پھر ایک بار پھر، تفتیش اس نکتے کا حصہ تھی، اور یہ انتہائی دلچسپ تھی۔

اس دوران، براہ کرم Fabrice AI کے ساتھ کھیلیں اور مجھے بتائیں کہ آپ کیا سوچتے ہیں!